定义:用于估计未知参数 $\theta$ 的统计量 $\hat{\theta}=\theta(x_1, x_2, …, x_n)$ 称为 $\theta$ 的估计量,或称为 $\theta$ 的点估计,简称估计。注意:点估计是统计量(样本的函数)

补充统计量定义:设 $x_1, x_2, …, x_n$ 为取自某总体的样本,若样本函数 $T=T(x_1, x_2, …, x_n)$ 中不含有任何未知参数,则称 $T$ 为统计量。统计量的分布称为抽样分布。

常用的点估计方法包括矩估计、极大似然估计、MUVE、BLUE、最大后验估计等

点估计是指使用样本数据构造样本统计量来估计总体参数时,使用一个点的数值表示“最佳估计值”。

与区间估计形成对比:区间估计通常是一个置信区间。

矩估计 Momnet

用样本矩替换总体矩,用经验分布替换总体函数。

理论基础:

- 格列文科定理(茆定理 5.2.1:当样本量相当大时,经验分布函数 $F_n(x) = \frac{1}{n} \sum_{i=1}^{n} I(X_i \leq x)$ 是总体分布函数 $F(x)$ 的一个良好的近似,这也正是经典统计学中一切统计推断都以样本为依据的原因)

- 一阶矩的收敛:若一阶矩存在(如 $E(X)<∞$),辛钦大数定律,或切比雪夫大数定律。

- 高阶矩的收敛:若高阶矩存在(如 $E(X^k)<∞$),强大数定律(将弱大数定律拓展到 k 阶矩)。

⚠️注意!

分母为$N-1$的方差的无偏估计 $\hat{\sigma}^2 = \frac{1}{N-1} \sum_{i=1}^{N} (x_i - \hat{\mu})^2$ 不是矩估计!有偏估计 $\hat{\sigma}^2 = \frac{1}{N} \sum_{i=1}^{N} (x_i - \hat{\mu})^2$ 才是。

极大似然估计 又名“事后诸葛亮估计”

极大似然估计(Maximum Likelihood Estimation, MLE)是一种基于样本数据估计概率模型参数的经典方法。其核心思想是:在给定观测数据的情况下,选择使得这些数据出现概率最大的参数值作为点估计值。

似然函数(Likelihood Function)是一个关于参数的函数,它表示在给定参数 $\theta$ 的情况下观察到数据 $X$ 的概率: $L(\theta)=L(\theta; X)=P(X|\theta)$. 从这个式子可以看出,似然函数是关于样本 $X$ 的函数,没错,似然函数的概念听起来很陌生,但实际上就是我们在概率论当中看到的各种概率分布 $f(x)$. 而极大似然估计就是找到使似然函数最大的参数 $\theta$, 即 $\hat{\theta}_{MLE} = \arg\max_{\theta} L (\theta) = \arg\max_{\theta} P (X|\theta)$

MLE 之所以又名“事后诸葛亮估计”,或“马后炮”估计,是因为它就是“看结果猜原因,怎么合理怎么来”;擅长解释已发生的事,但未必能预测未来。

引入亿点贝叶斯

人人都应该懂一些贝叶斯。

理解贝叶斯公式

贝叶斯后验概率 $P(\theta_i|X)=\frac{P(X|\theta_i)×P(\theta_i)}{P(X)}=\frac{L(\theta_i|X)·P(\theta_i)}{P(X)}=\frac{似然×先验}{边缘概率(配分函数)}$

其中分母部分 $P(X)=\sum P(X|\theta)·P(\theta)=P(X|\theta_i)·P(\theta_i)+\sum_{k≠i}P(X|\theta_k)·P(\theta_k)$

故可将后验概率表示为 $P(\theta_i|X)=\frac{P(X|\theta_i)×P(\theta_i)}{P(X|\theta_i)·P(\theta_i)+\sum_{k≠i}P(X|\theta_k)·P(\theta_k)}$, 总这个式子可以比较直观地反映出贝叶斯使用样本更新后验概率的思想:若 $P(X|\theta_i)×P(\theta_i)$ 值↑,说明 $\theta_i$ 是参数真值的可能性大,应该给它更高的比重;反之则给它更小的比重。

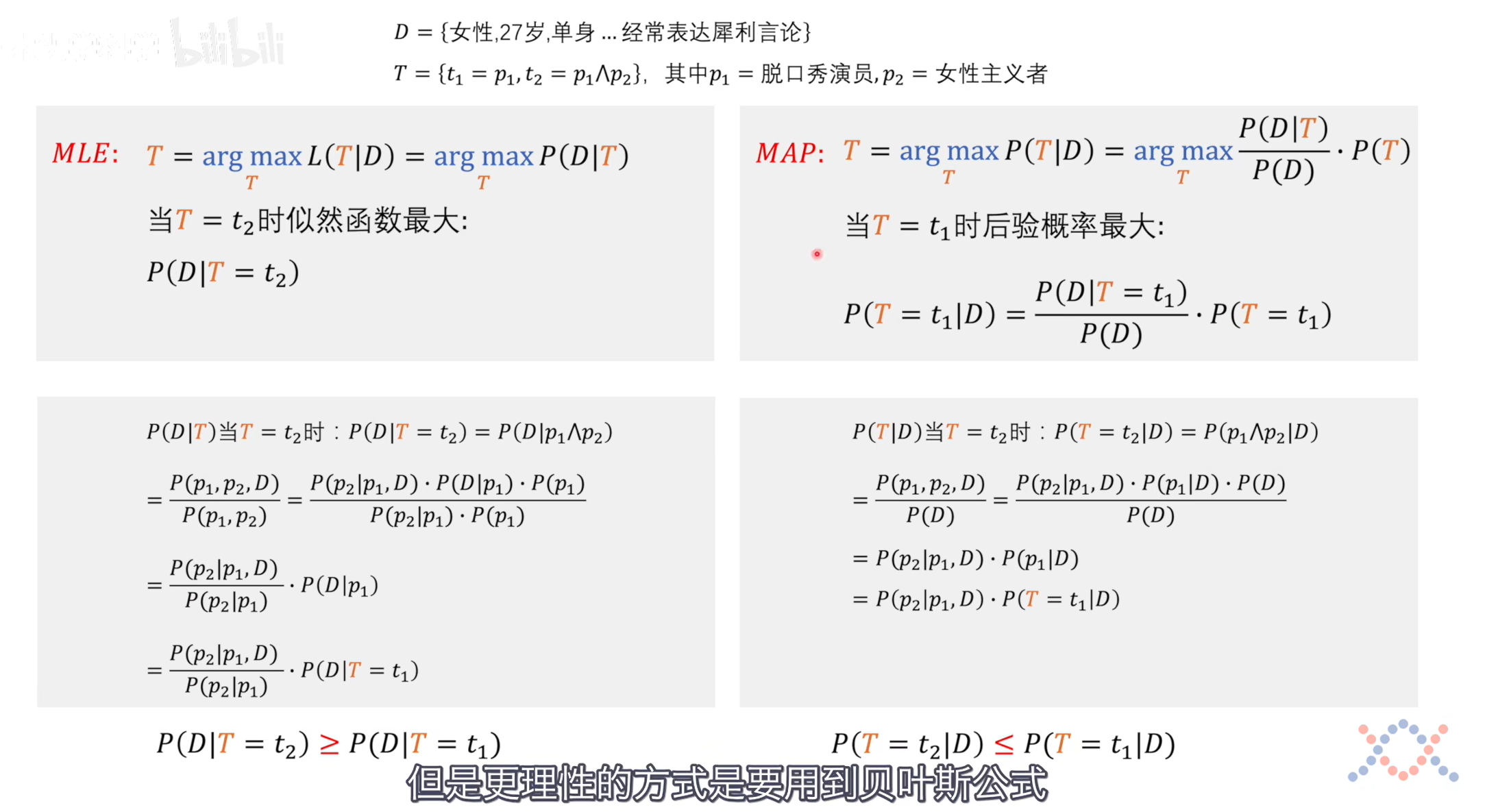

MLE VS MAP(Maximum A Posteriori)

最大似然估计的目标是最大化似然函数;而最大后验估计的目标则是最大化后验概率,相对于最大似然估计额外还考虑了先验概率的影响。

而 MLE 假设模型是均匀分布,即先验概率P(θ)=1。可以说,MLE是MAP的一种特例

我们的直觉是按照最大似然估计的方式去思考的,但是更理性的方式是要用到贝叶斯公式,用最大后验估计的方式去思考。通过这个问题我们也可以发现:人类的直觉很多时候不靠谱,不靠谱的原因,很可能就是我们的直觉没有用贝叶斯的方式去思考。

人的思维模式不就是贝叶斯吗,人工智能有望突破意识枷锁!!!

—— 上图和文本来自视频 贝叶斯解释“L1和L2正则化”,本质上是最大后验估计。如何深入理解贝叶斯公式?

再举个例子?🤔

- 怎么理解贝叶斯后验概率公式? #统计学 ✅ 2025-03-08

古典频率学派 VS 贝叶斯学派

说到贝叶斯,就不得不提及古典频率学派和贝叶斯学派:

- 频率学派(古典统计学):认为参数真值是固定的且未知的常数,观察到的数据是随机的。

- 具体做法:根据大数定律,通过大量重复试验,用频率逼近概率

- 贝叶斯学派:贝叶斯学派认为参数真值不是固定的,是一个随机变量,而观察到的数据是固定的。这个随机变量可用一个概率分布去描述,这个分布称为先验分布,

- 具体做法:开始时给定先验概率,通过数据不断修正,最后得出后验概率,或后验分布。因引入主观的先验分布而受到大量质疑,但记得在一个视频里讲到过:随着修正的不断进行,先验分布的“权重”也在不断下降。

| 置信区间 (confidence interval, CI) |

可信区间 (credibility interval,CI) |

|

|---|---|---|

| 学派 | 古典统计学派,或频率学派 | 贝叶斯学派 |

| 观点 | 参数是一个未知的常数 | 参数是随机变量 |

| 两个区间的区别 | 对于一个给定的 95% 置信区间,含义是:构造区间 100 次,有 95 次包含参数真值。 | 对于一个给定的 95% 可信区间,含义是:参数真值有 95% 的概率落入该区间内。 |

回归 MLE:MLE 与 Bayes 的区别

要将『似然函数』与『后验概率』相区别:与似然函数 $P(X|\theta)$ 恰好相反,后验概率是在给定数据 $X$ 后,参数 $\theta$ 的概率 $P(\theta|X)$. 注意是参数 $\theta$ 的概率。进一步地,『后验分布』则是关于参数 $\theta$ 的分布。

MLE 不具有唯一性

$\hat{\beta}=(X^TX)^{-1}X^TY$

唯⼀性条件: 如果似然函数是严格凸的,且数据满⾜⼀定的正则条件, $(X^TX)$ 可逆,那么极⼤似然估计的结果是唯⼀的。例如,在⾼斯分布中,均值和⽅差的极⼤似然估计是唯⼀的。对于简单的模型(如线性回归),极⼤似然估计通常有唯⼀解。

⾮唯⼀性情况: 似然函数⾮凸或多峰,或者数据存在共线性问题, $(X^TX)$ 不可逆,极⼤似然估计可能会有多个局部极⼤值,导致解不唯⼀。

矩估计 VS 极大似然估计 常考!

| 矩估计 | 极大似然估计 |

|---|---|

| 原理简单、使用方便、计算便捷 | 计算复杂 |

| 可以在不知道总体分布但知道样本矩的情况下对总体进行推断 | 需在总体分布已知的情况下才能使用(需对总体分布做假设) |

| 未充分利用样本信息,即不一定是充分统计量的函数,估计精度不高,只有当样本量较大时才能保证其优良性 | 充分利用样本信息,一般都与充分统计量有关,估计精度高 |

| 一般情况下具有相合性 | 具有不变性和渐进正态性,大样本下也具有相合性 |

| 不适用于总体矩不存在的分布,如柯西分布 | 不唯一性 |

MVUE 等

Rao-Blackwell 定理:假设 $g(X)$ 是 $\theta$ 的一个任意估计, $T$ 是一个充分统计量。那么 $g(X)$ 相对于给定 $T(X)$ 的条件期望是一个比 $g(X)$ 更好的估计量(至少不差于)。

由于MVUE不一定总能达到C-R下界,这个定理提供了不用C-R下界的寻找MVUE的方法。

定理告诉我们,通过条件期望,可以利⽤充分统计量改进估计量的效率。

评估点估计的标准

很多概念,需要多过几遍,晕🥴

无偏性

定义:若对 $\forall \theta \in \Theta,$ 有 $E_\theta(\hat{\theta}) = \theta$ 则称 $\hat{\theta}$ 为 $\theta$ 的无偏估计。

并非所有参数都存在无偏估计。

参数是否可估:取决于是否有无偏估计。

有效性

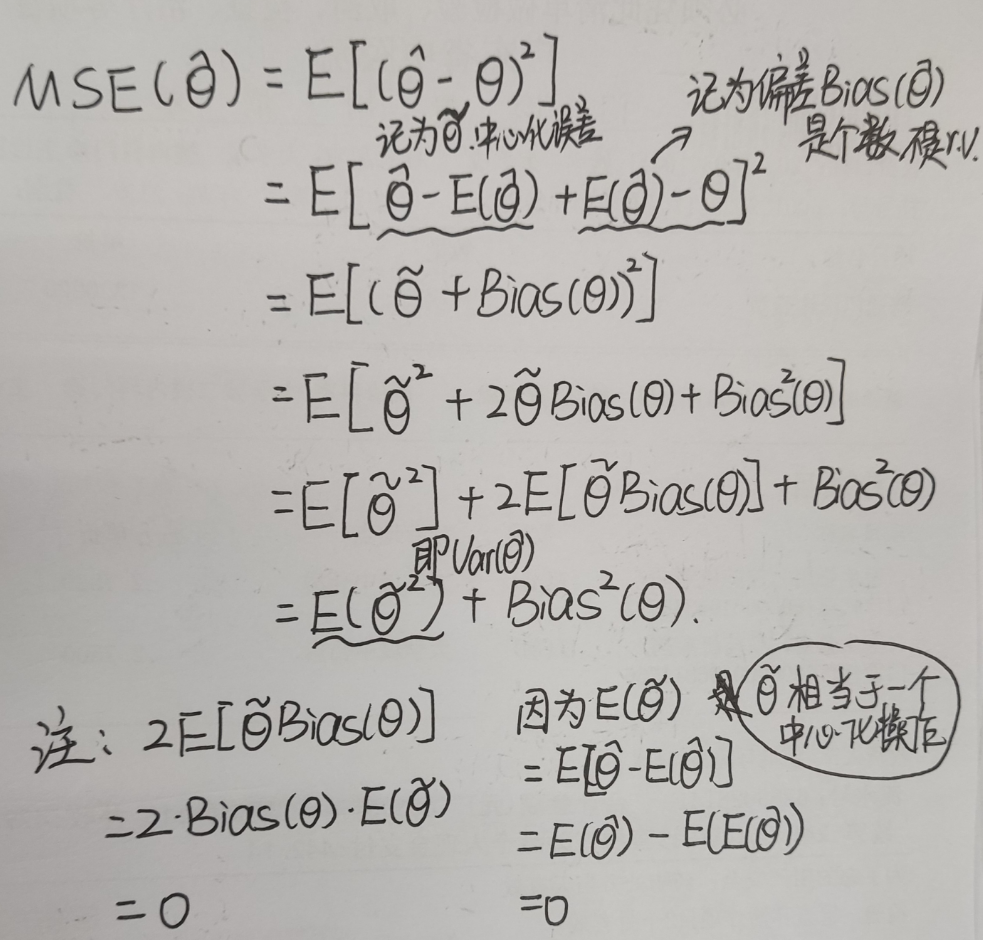

无偏估计比较方差,有偏估计比较均方误差。

方差一般用来计算样本的离散程度,而均方误差则可以用做衡量模型拟合的一个度量

无偏估计量不一定是最有效的!

附:MSE 分解公式推导:

大样本情形 - 相合性,又称一致性 Consistency

弱相合性,当样本量 $n \to \infty$ 时,估计量 $\hat{\theta}_n$ 依概率收敛于真实参数 $\theta.$ 记为 $\hat{\theta}_n \xrightarrow{P} \theta$ 即 $\forall \epsilon > 0, \quad \lim_{n \to \infty} P\left (|\hat{\theta}_n - \theta| \geq \epsilon\right) = 0.$

弱相合性被认为是对估计的一个最基本的要求,如果一个估计量,在样本量不断增大的时,他都不能把被估参数估计到任意的指定的精度 $\varepsilon$ ,那么这个估计是很值得怀疑的。通常,不满足弱相合性要求的估计不予考虑。

弱相合估计不止一个:样本有偏方差和样本无偏方差都是 $\sigma^2$ 的相合估计。

弱相合性判定:$lim_{n \to \infty}E(\hat{\theta}_n)=\theta, \quad lim_{n \to \infty}Var(\hat{\theta}_n)=0$

强相合性,当样本量 $n \to \infty$ 时,估计量 $\hat{\theta}_n$ 几乎必然收敛于真实参数 $\theta$

即 $P\left (\lim_{n \to \infty} \hat{\theta}_n = \theta\right) = 1.$ 也称 $\hat{\theta}_n$ 几乎必然(Alomst Sure)收敛到 $\theta$, 记为 $\hat{\theta}_n \xrightarrow{a.s.} \theta.$

强弱相合性之间的差异类似强弱大数定律之间的差异:

| 弱大数定律 | 强大数定律 |

|---|---|

| 依概率收敛 | 几乎必然收敛 |

| $\bar{X}_n \xrightarrow{P} \mu$ | $\bar{X}_n \xrightarrow{a.s.} \mu$ |

| 允许样本均值无限次偏离 $\mu$(但概率趋近于零)例如抛硬币实验中偶尔出现连续多次正面 | 彻底排除了无限次偏离的可能,确保样本均值最终“锁定”在 $\mu$ 附近 |

由强大数定律可知,矩估计总是相合的。

大样本情形 - 渐进正态性

当样本容量趋向无穷大时,某些估计量(如最大似然估计)会收敛到一个正态分布。

在相合性的基础上进一步关注收敛速度和分布特性。

极大似然估计具有渐进正态性。

不变性

定义:如果某一个统计量 $T(x)$ 是某个参数 $\theta$ 的无偏估计具有某个性质,将统计量经过 $g$ 变换之后为 $g(T(x))$,变换后的参数 $g(\theta)$ 同样具有原有性质。

极大似然估计具有不变性,完备性具有不变性,矩估计也具有不变性

无偏估计不具有不变性,若 $\hat{\theta}$ 是 $\theta$ 的无偏估计, $g(\hat{\theta})$ 则不一定是 $\theta$ 的无偏估计,除非 $g(\theta)$ 是线性函数;

充分性不具有不变性,除非 $g(\theta)$ 是严格单调函数

相合性不具有不变性,除非 $g(\theta)$ 是连续函数

...